揭秘世界杯首次数智手语解说——数字人主播弋瑭的幕后制作技术

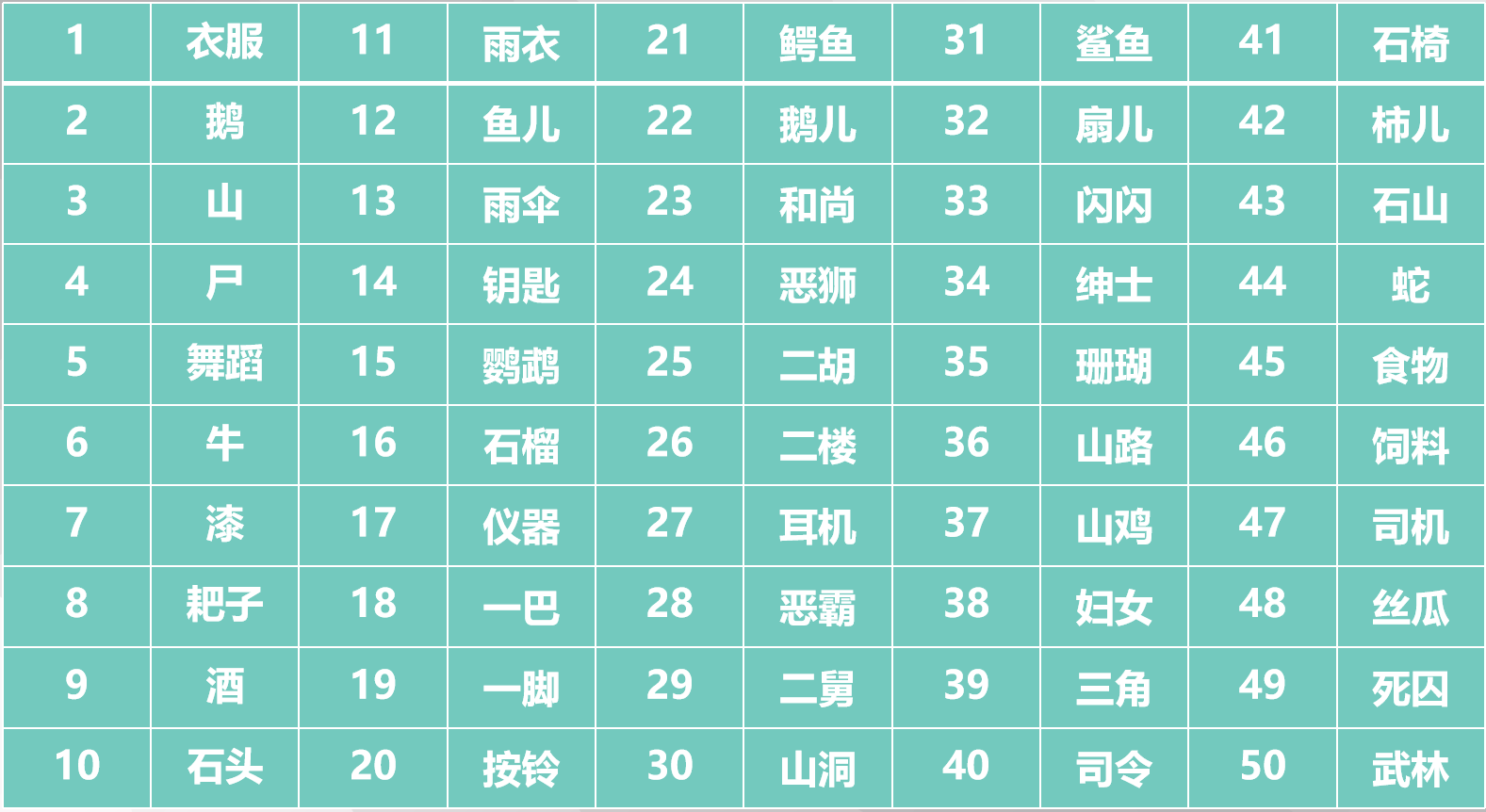

整体技术路线

直播技术框架

直播运营系统:所有直播频道的任务下发。

能力开放平台:接收运营系统任务,并将相关技术参数下发给相关技术平台和系统。

字幕转译平台:针对直播源流进行实时AI字幕转译,输出WS字幕流。

演播室系统:对手语数字人进行实时、高精度渲染、抠像,并实现与直播源流的实时合成输出。

直播混流系统:对演播室合成流、字幕流进行编码混流,输出最终直播流给直播频道,完成直播流程。

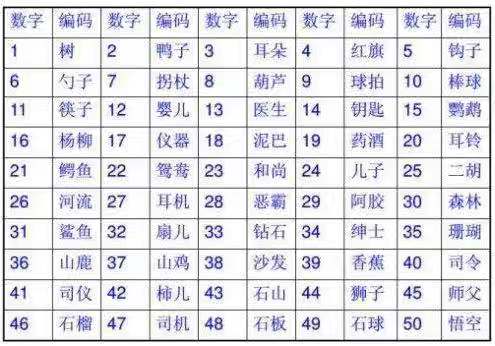

关键技术

高精准驱动字幕

中文语义蒸馏与分词快编

人体三维结构化参数表征

快速人体三维运动数据捕捉

高逼真度3D渲染