徐谦超级记忆术,解密 - ChatGPT为何能“打败”众多大模型,除了千亿级参数,还有什么?

每经记者:文巧 每经编辑:高涵

ChatGPT在互联网上的风暴已经上演了许久。近期,在谷歌Bard和微软必应(Bing)接连翻车的情况下,市场对ChatGPT的态度已经从“新鲜”开始向“理性”过渡。不过,国内外资本对ChatGPT的热捧仍然有持续之势。

诚然,全世界都见证了ChatGPT的强大,但实际上,在自然语言处理(NLP)领域, ChatGPT并非第一个基于大型语言模型的产物。早在2018年,NLP领域演变出来的另一个产物BERT问世,一度被认为在自然语言理解类任务中发挥得非常出色。

那么,是什么让ChatGPT一经问世就获得了前所未有的关注?它到底强大在哪里?凭什么在众多大型语言模型中脱颖而出?

关于上述问题,《每日经济新闻》记者采访了马萨诸塞大学(又称麻省大学)洛厄尔分校计算机科学教授Jie Wang。他认为,ChatGPT最主要的突破在于其背后架构GPT-3.5中使用的few-shots(小样本)和用户反馈的技术。而且,ChatGPT拥有其他语言模型所不具备的千亿级别参数规模,也允许它能够捕获更复杂的语言模式和关系。

人类已经经历了数次超级工具的诞生,例如,互联网和智能手机,其引发的科技革命极大地改变了人们的思维和生活方式。在Jie Wang看来,如果用ChatGPT来代表基于大型通用语言模型的应用,那么ChatGPT有潜力成为下一个改变世界的超级工具。

技术原理:一场“概率游戏”

ChatGPT之所以能够成为一个现象级的火爆应用,在于它能够自动生成类似于人类撰写的文本,这一点非常引人注目,也非常出乎意料。那么,为什么ChatGPT能够如此出色地生成有意义的文本呢?

我们先从ChatGPT所属的NLP领域说起。NLP,即自然语言处理,是人工智能的一个领域,专注于让计算机能够理解、解释和生成人类语言。

人类语言非常丰富和微妙,可以根据上下文、语气和其他因素以多种不同的方式表达,如何处理人类语言的复杂性和可变性也成为NLP领域的主要任务之一。NLP技术是ChatGPT能够出色地生成类似于人类撰写的文本的基础。

“最先进的NLP技术是文本到文本的转换,它基于一个超大型的多层编码器-解码器神经网络,这个神经网络能在超大规模的无监督数据集上对数十亿参数进行训练,“在谈及NLP时,Jie Wang向《每日经济新闻》记者介绍道。

在对NLP的主要任务有一个基本的理解之后,我们再来谈谈ChatGPT的技术原理。众所周知的是,ChatGPT是一种聊天机器人产品,它基于OpenAI的大型语言模型架构GPT-3.5。

2月15日,计算机科学家Stephen Wolfram在推特发表了一篇万字长文来解释ChatGPT的工作原理。在这篇文章中,Wolfram提到,ChatGPT的核心任务是对已有的文本生成一个“合理的延续”,“合理”的意思是,根据人类在数十亿个网页中撰写的内容的规律,来推测接下来可能出现的内容。

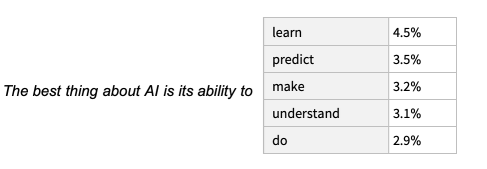

Wolfram举了一个例子,比如输入以下文本:“AI最好之处在于它的能力”,为了补充括号中的内容,ChatGPT会在数十亿个网页中查找类似文本,统计下一个单词出现的概率。最终,ChatGPT会生成一个可能的单词列表,并给出每个单词的概率排名。这就是它的“概率游戏”。

图片来源:文章截图

脱颖而出的背后:创新训练方式、千亿参数规模

实际上,ChatGPT并非第一个基于大型语言模型的产物。早在2018年,NLP领域演变出来的另一个基于大型语言模型的产物——BERT已经出世,并一度被认为在自然语言理解类任务中发挥得非常出色。那么,为什么相比之下,只有ChatGPT能够引起如此大的轰动呢?

首先在于GPT-3.5训练方式上的创新。

GPT-3.5的前身是GPT-3。据Jie Wang介绍,“GPT-3之前的大型语言模型,通常是通过在非常大的数据集上使用自我监督学习的方式,来计算多个任务的单词和句子之间的上下文关系,从而达到训练深度神经网络的目的。不过,这样一个经过训练的模型仍然需要进行微调(fine-tuning)来执行特定任务。”

值得注意的是,BERT所使用的方式就是微调。这种方式的局限性就在于,“微调既费时又费钱,”Jie Wang说道,“通常需要特定的标记数据集。”

当GPT-3出现后,问题得到了解决,这也是ChatGPT最具突破性的创举的基础。“GPT-3仅使用几个特定的任务示例来简化微调的过程,这些任务示例被称作‘few shots’(小样本),”Jie Wang解释道,“它产生的结果与最先进的微调过程获得的结果相同或相似,这项技术大大提高了生产率。GPT-3.5则进一步使用用户反馈来提高few shots生成结果的准确性。”

也就是说,“(ChatGPT)主要的突破是GPT-3.5中使用的‘few-shots’结合用户反馈的技术,”Jie Wang向《每日经济新闻》记者总结道。

(编者注:few shots learning即小样本学习,在机器学习领域中泛指从少量标注数据中学习的方法和场景。)

那么,如何来理解few shots呢?这里我们需要理解另一个概念——提示(prompting)。“提示是ChatGPT接受用户反馈的形式,”Jie Wang说道。

prompting实际上就是给模型一点小提示。举一个非常简单的例子,当每经记者使用ChatGPT辅助新闻写作时,需要ChatGPT对一段较长的新闻进行归纳总结或生成一个标题。这时,可以给ChatGPT一点小提示——例如,Mary是“《纽约时报》”一位“非常资深”的编辑,她需要几个“吸睛的”标题。

通过引号中三个关键词的提示,相比于简单地要求“生成一个标题”,这些小提示会让ChatGPT生成的内容得到明显提升。

其次,ChatGPT的强大还在于其超大的参数规模。ChatGPT基于8000亿个单词的语料库(或45TB的文本数据),包含了1750亿个参数。8000亿是ChatGPT的训练数据,1750亿是它从这些训练数据中所学习、沉淀下来的内容。

“之前最大的模型也只是百亿参数,不是千亿级别的,”Jie Wang说道。公开资料显示,这种更大的参数规模允许ChatGPT能够捕获更复杂的语言模式和关系,从而提高复杂自然语言处理任务的准确性。

据美国《时代周刊》上月中旬的报道,为了训练ChatGPT,OpenAI雇佣了时薪不到2美元的肯尼亚外包劳工,他们所负责的工作就是对庞大的数据库手动进行数据标注。报道中提到,OpenAI在2021年底与位于旧金山的外包公司Sama签署了三份总价值约20万美元的合同,为其数据库中的有害内容进行标记。

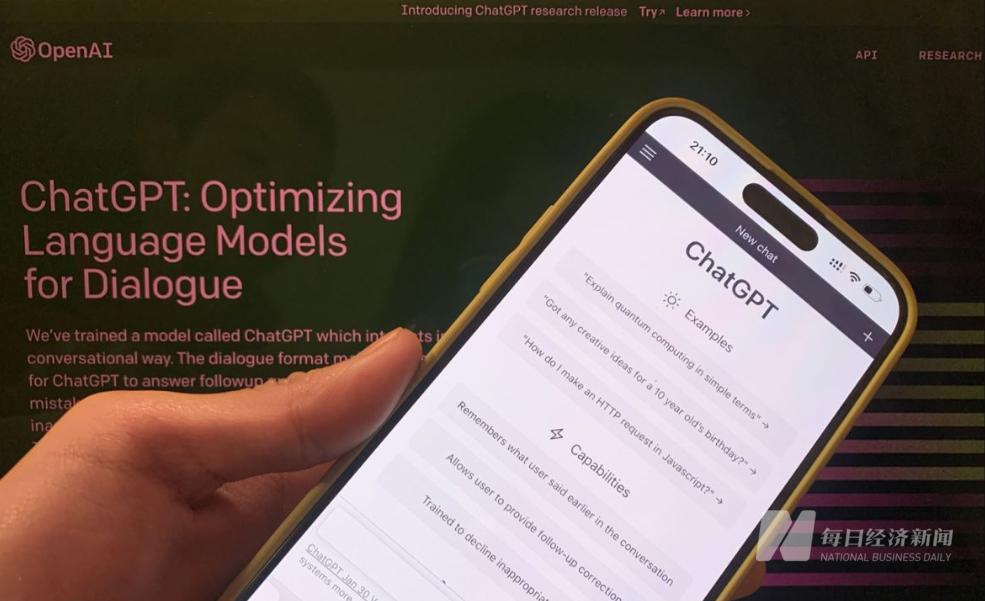

图片来源:每日经济新闻 刘雪梅 摄(资料图)

商业落地:离通用AI还有多远?

ChatGPT已经展现了在NLP领域的强大能力,那么,它是否可以从NLP领域走向其他AI领域呢?

Jie Wang认为答案是肯定的。“在T5、GPT-3和GPT-3.5中发展起来的主要技术,即自我监督学习、few-shot微调,以及结合用户反馈的方式,当然可以在其他AI领域进一步修改和应用,”他向《每日经济新闻》记者说道。

看看BERT就知道了,虽然“出身”于NLP领域,但已经广泛应用于其他AI领域。据Jie Wang介绍,BERT这类语言模型,基于递归神经网络(RNN)、双向长短期记忆(Bi-LSTM)等来计算捕获潜在语义和句法信息的单词和句子,这些神经网络构建技术已广泛应用于图像处理等其他领域。

科技研究和咨询公司Gartner在近期发布的一篇报告中提及了ChatGPT的集中应用方向,一是开放API访问权限。据悉,微软就计划为即将推出的Azure OpenAI ChatGPT提供API;二是在销售、营销、个性化教育以及个性化医疗保健领域得以应用。

不过,目前来看,ChatGPT广泛的商业落地仍然还有一些难题。“我能看到的其中一个障碍是,ChatGPT提供的结果是不可信任的,”Jie Wang说道。

OpenAI的首席执行官Sam Altman此前也曾在推特上表示,ChatGPT还有很大的局限性,它在某些方面非常出色以至于给人一种误导的印象。“现在依赖它来做任何事情都是错误的,我们在稳健性和准确性上还有很多工作要做,”他这样写道。

在许多人的幻想中,未来的某一天,会出现具备与人类同等智慧、或超越人类的AI,能表现正常人类所具有的所有智能行为,它能思考、能判断,有思想、有伦理——这就是通用AI。ChatGPT能够引起如此轰动的原因也在于,有人认为,它的出现似乎让世界看到了通用AI的曙光。

人类已经经历了数次超级工具的诞生,互联网和智能手机的出现引发了科技革命,并且极大地改变了人们的思维和生活方式。在Jie Wang看来,如果用ChatGPT来代表基于大型通用语言模型的应用,那么ChatGPT有潜力成为下一个改变世界的超级工具。“我认为它有可能改变人们开展业务的方式,”他说道。

不过,现实情况是,ChatGPT离通用AI的终点,仍然还有一段很长的路要走。

每日经济新闻

怎样让记忆力提高,鱼的记忆力只有七秒,草根秀:八岁神童过目不忘 超强记忆堪称最强大脑

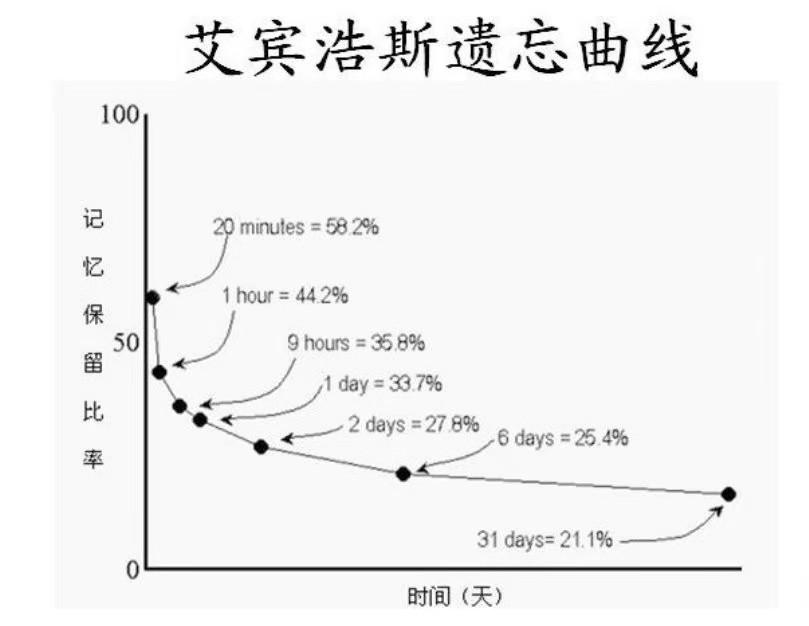

过目不忘记忆力训练,怎样让记忆力提高,期末阶段适用于小学高年级及中学的超强记忆方法:循环记忆法!

记忆大师课,一分钟记忆术,记忆专家周日再次免费授课,预约请从速

最强大脑记忆力课程,记忆大师课,学习力差的人正被社会所淘汰,《无限可能》教你练就快速学习力

精选推荐

- [记忆方法] 最有效的备考方法,法考如何备考,2021年高考备考:8种高效记忆方法

- [记忆方法] 考前快速大量记忆技巧,最有效的备考方法,考前冲刺:一消备考也要动脑筋,这样记忆方法大多数考生并不知道

- [记忆方法] 怎样快速记忆知识点且记得牢,考前快速大量记忆技巧,会计从业备考不放假,六大归纳记忆法带你飞!

- [记忆方法] 快速记忆方法的小窍门,怎样快速记忆知识点且记得牢,这些记忆方法让你学习、备考的效率大大提升!

- [精品记忆课] 记忆课程有没有效果,记忆力课程,“超强记忆”吸引家长买了课,没上几节校长就失联,41名家长能要回16万余元的培训费用吗?

- [精品记忆课] 最强大脑记忆训练法视频,记忆课程有没有效果,超强记忆系统课_第2节 底层逻辑篇 超强记忆系统课_第2节

- [古诗词记忆] 孩子记忆力差,背书困难怎么办,有什么快速背书的方法,有用的背书方法,快收藏码住吧~

- [记忆方法] 记忆的方法和技巧,记忆宫殿训练方法,技巧:熟记这些顺口溜,轻松记忆历史朝代知识

- [记忆方法] 历史朝代记忆口诀,记忆的方法和技巧,我国历史朝代顺序记忆口诀

- [古诗词记忆] 文科怎么背怎样才能记得住,文科背书怎么背得快又牢固,文科成绩难提高?你需要这12个方法